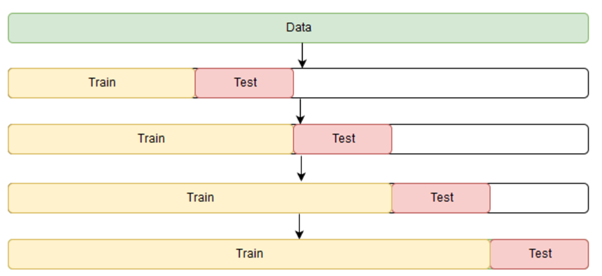

如何得到和 Anaconda 的 Jupyter Notebook 一樣的使用者體驗但卻不需安裝 Anaconda ?

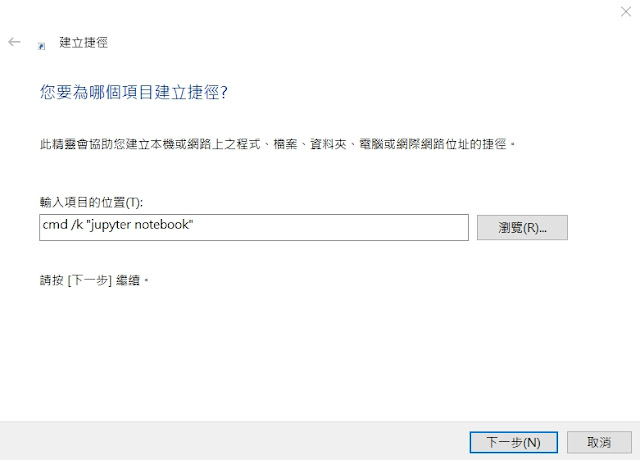

身為一個資料科學家或是機器學習工程師,Jupyter Notebook 是必不可少的好用工具,而 Anaconda 則是在入門這個領域的時候為了減少痛苦而安裝的一個龐大軟體。 但實際上大部分時候我們只需要 Anaconda 中的 Jupyter Notebook,而不是它內含的其他東西以及Python 環境選擇 (我不如用 pipenv...),若是你像我一樣希望捨棄笨重的 Anaconda,但又希望獲得同樣的體驗,而不是每次都要打開 terminal,輸入 Jupyter Notebook 才能打開的話,這篇會是一篇適合你閱讀的文章。 Anaconda 上的體驗是怎樣的? 若是以只使用 Jupyter Notebook 為前提的話,它主要的方便在於安裝 Anaconda 之後會自動產生一個 Jupyter Notebook 的捷徑在開始工具欄,當你需要使用的時候就直接點開就好。而不用打開 terminal 打字什麼的。 (我很在意這個所以一直被 Anaconda 綁架......) 除此之外,Anaconda 的 Jupyter Notebook 路徑是固定的,每次開啟都會在 username 那個資料夾裡面,所以我得因此被其綁架而得把所有資料和 Notebook 都放在那個資料夾裡面。 所以,接下來就要開始如何將 Jupyter Notebook 以一個有 icon 的桌面捷徑開啟而且還可以基於開啟的路徑而開啟的教學。 安裝 Jupyter Notebook pip install notebook 建立 Jupyter Notebook 捷徑 首先要在桌面上右鍵新增 -> 建立捷徑,然後在項目位置中打入 cmd /k "jupyter notebook" , 如下圖。 然後就將捷徑命名為 jupyter notebook,或是其他你喜歡的名字,像是 AI 煉蠱場之類的。 這串項目位置的意思是當點擊這個捷徑的時候會做兩個動作 : 1. 打開 cmd 2. 自動打入 jupyter notebook 改變 Jupyter Notebook Icon 這步很簡單,總之就是去下載 jupyter notebook 的 icon (記得轉成 .ico 檔名),然後儲存在電腦中的某一處。接下來只要右鍵點開 -> 內容